Künstliche Intelligenz hat in den letzten Jahren große Fortschritte gemacht. Eine der beeindruckendsten Entwicklungen ist die Fähigkeit von KI, realistisch wirkende Bilder zu erzeugen. Doch diese Technik hat nicht nur positive Seiten. Sie kann auch dazu genutzt werden, Fake News noch glaubhafter zu machen. Dadurch wird es immer schwieriger, Wahrheit und Manipulation zu unterscheiden.

Wie KI-Bilder entstehen

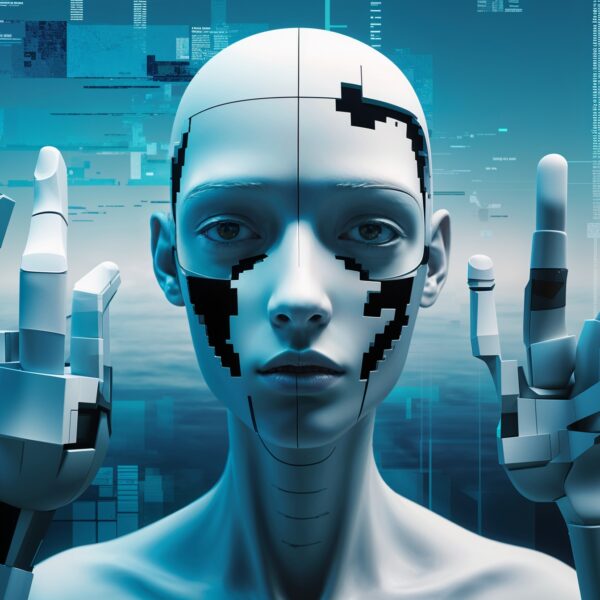

Moderne KI-Modelle können Bilder generieren, die kaum von echten Fotos zu unterscheiden sind. Diese Systeme, sogenannte Generative Adversarial Networks (GANs), bestehen aus zwei KIs: Eine erstellt das Bild, die andere bewertet es und gibt Feedback. So wird das Bild mit jeder Iteration realistischer. Eine weitere Methode sind sogenannte Diffusionsmodelle, die Bilder schrittweise aus einem Grundrauschen entstehen lassen. Diese Technologien haben dazu geführt, dass KI-generierte Bilder inzwischen unglaublich detailreich und realistisch wirken.

Fake News und KI-Bilder: Eine gefährliche Mischung

Fake News gibt es schon lange, doch mit KI-Bildern haben sie eine neue Dimension erreicht. Fake News leben davon, Menschen gezielt in die Irre zu führen. Mit Hilfe von KI-generierten Bildern können diese Falschmeldungen noch glaubhafter erscheinen. Ein manipuliertes Foto oder eine realistisch wirkende Szene, die es nie gegeben hat, können das Meinungsbild der Öffentlichkeit beeinflussen. Besonders in sozialen Netzwerken verbreiten sich solche Bilder rasant. Oft werden sie ohne kritisches Hinterfragen weitergeleitet.

Beispiele für KI-Bilder in Fake News

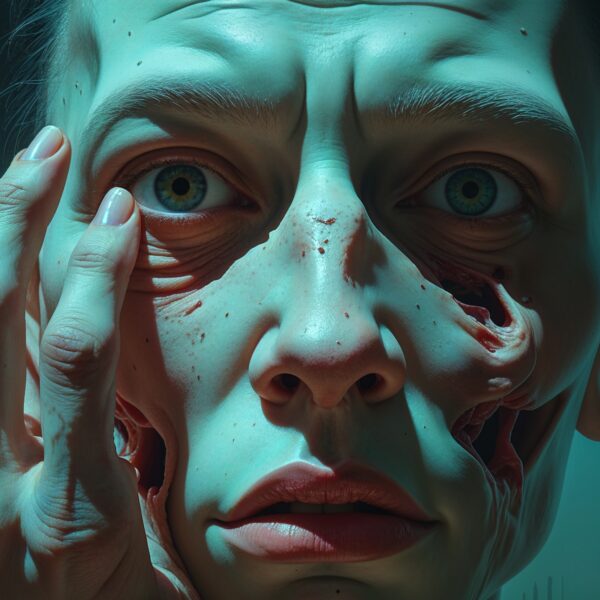

Ein bekanntes Beispiel sind sogenannte „Deepfake“-Bilder, bei denen Gesichter von echten Personen auf andere Körper übertragen werden. Diese Technik kann genutzt werden, um Prominente oder Politiker in Situationen zu zeigen, die nie stattgefunden haben. Ein weiteres Beispiel sind Szenen von Katastrophen oder Kriegen, die nur in der Fantasie der KI existieren. Solche Bilder können Emotionen schüren und Menschen gezielt manipulieren.

Warum KI-Bilder so glaubwürdig wirken

KI hat gelernt, realistische Details wie Schatten, Lichtverhältnisse und Texturen perfekt nachzuahmen. Dadurch entstehen Bilder, die selbst Fachleute auf den ersten Blick kaum von echten Fotos unterscheiden können. Hinzu kommt, dass wir in einer Welt leben, in der Bilder oft mehr als Worte sagen. Ein Bild löst sofort Emotionen aus und bleibt länger im Gedächtnis als ein Text. Deshalb sind KI-generierte Fake-Bilder besonders wirkungsvoll.

Welche Gefahren entstehen dadurch?

Die größte Gefahr liegt in der Manipulation der Öffentlichkeit. KI-Bilder können genutzt werden, um politische Meinungen zu beeinflussen, Rufmord zu betreiben oder gezielt Panik zu verbreiten. Besonders in Krisenzeiten kann das gravierende Folgen haben. Wenn Menschen nicht mehr sicher sein können, ob ein Bild echt oder gefälscht ist, kann das Vertrauen in Medien und offizielle Berichterstattung schwinden.

Auch für Privatpersonen kann das gefährlich werden. Ein KI-generiertes Bild kann dazu genutzt werden, um jemanden in eine kompromittierende Situation zu versetzen. Schon heute gibt es Berichte von gefälschten Bildern, die dazu verwendet wurden, um Personen zu erpressen oder zu verleumden.

Wie kannst du Fake-Bilder erkennen?

Auch wenn KI-Bilder immer realistischer werden, gibt es Möglichkeiten, sie zu entlarven. Oft sind die Details nicht ganz perfekt. Finger oder Hände sehen manchmal merkwürdig aus, oder es gibt Unregelmäßigkeiten in der Lichtführung. Auch Hintergrundelemente können verzerrt oder unlogisch wirken. Wenn du dir bei einem Bild unsicher bist, kannst du eine Rückwärtssuche mit Google Lens oder anderen Tools machen. So findest du heraus, ob das Bild bereits in einem anderen Zusammenhang verwendet wurde.

Eine weitere Möglichkeit ist, auf die Quelle des Bildes zu achten. Stammt es von einer vertrauenswürdigen Nachrichtenseite oder wurde es nur auf einer unbekannten Social-Media-Seite geteilt? Kritisches Denken ist hier der beste Schutz.

Was wird gegen KI-Fakes unternommen?

Um die Gefahr durch KI-Bilder einzudämmen, arbeiten Forscher an verschiedenen Lösungen. Einige Unternehmen entwickeln Wasserzeichen-Technologien, mit denen KI-generierte Bilder gekennzeichnet werden können. Andere setzen auf Algorithmen, die erkennen können, ob ein Bild von einer KI stammt. Doch es bleibt ein Wettrennen zwischen Technik und Betrug.

Regierungen und Plattformen setzen ebenfalls Maßnahmen um. Einige Social-Media-Dienste haben begonnen, Fake-Bilder zu kennzeichnen oder zu löschen. Auch Gesetze gegen Deepfakes und manipulierte Medien werden diskutiert. Doch eine hundertprozentige Sicherheit wird es wohl nie geben.

Fazit: Wachsam bleiben in der digitalen Welt

KI-Bilder sind eine faszinierende Technologie mit vielen positiven Anwendungsmöglichkeiten. Doch sie bergen auch Gefahren, besonders wenn sie zur Verbreitung von Fake News eingesetzt werden. Deshalb ist es wichtiger denn je, sich kritisch mit digitalen Inhalten auseinanderzusetzen.

Wenn du ein Bild siehst, das zu schockierend oder spektakulär wirkt, um wahr zu sein, dann lohnt es sich, genauer hinzuschauen. Die Fähigkeit, Wahrheit von Manipulation zu unterscheiden, wird in Zukunft immer wertvoller. Informiere dich, bleibe skeptisch und hinterfrage Inhalte – so kannst du dich vor Fake News und KI-Manipulationen schützen.